Искусственные нейронные сети презентация

Содержание

- 2. Литература Хайкин С. Нейронные сети. Полный курс, 2-е изд. – М.:

- 3. Искусственные нейронные сети – вычислительные структуры, которые моделируют процессы человеческого мозга

- 4. Немного истории 1904 С.Рамон-и-Кахаль Открытие нейронов – нервных клеток 1943 У.Мак-Каллок,

- 5. Немного истории 1957 В.И.Арнольд, А.Н.Колмогоров Решение 13 проблемы Гильберта: любую непрерывную

- 6. Немного истории 1986 Д.Румельхарт, Дж.Хинтон, Р.Вильямс Метод обратного распространения ошибки Середина 1980х Нейросетевой

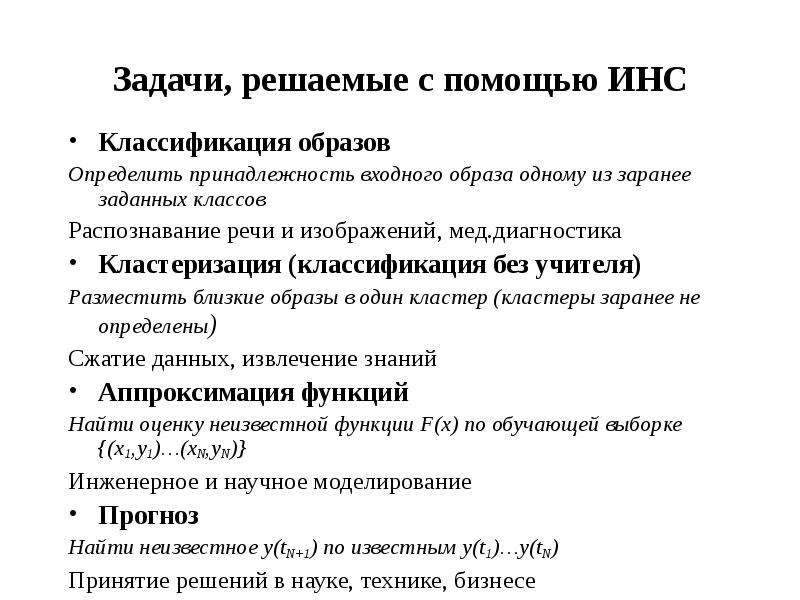

- 7. Задачи, решаемые с помощью ИНС Классификация образов Определить принадлежность входного образа

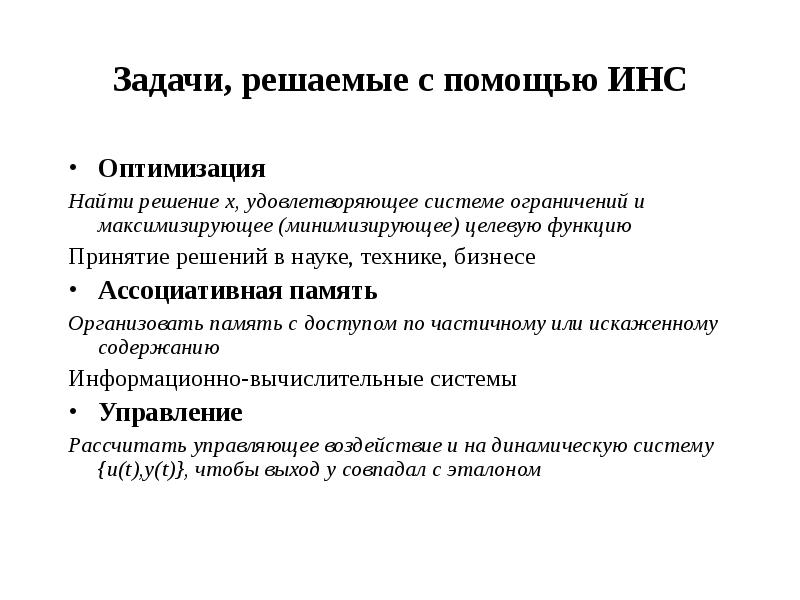

- 8. Задачи, решаемые с помощью ИНС Оптимизация Найти решение x, удовлетворяющее системе

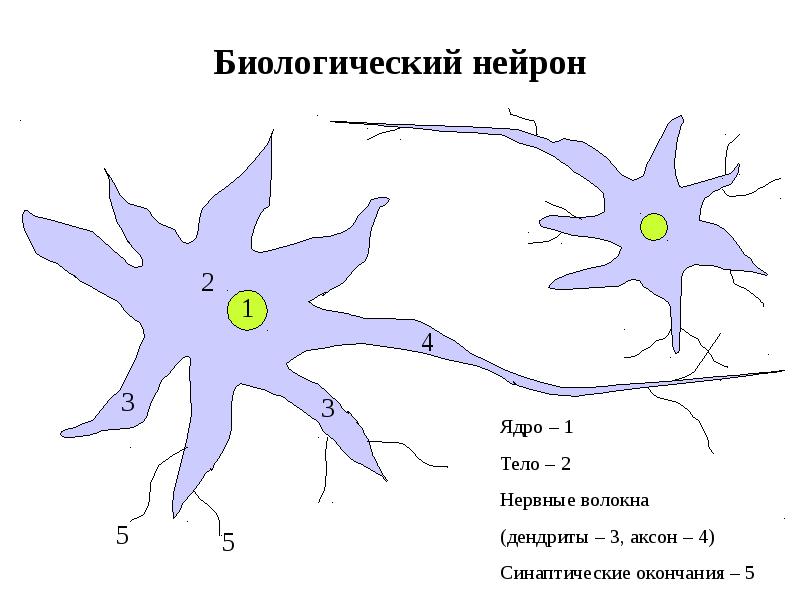

- 9. Биологический нейрон

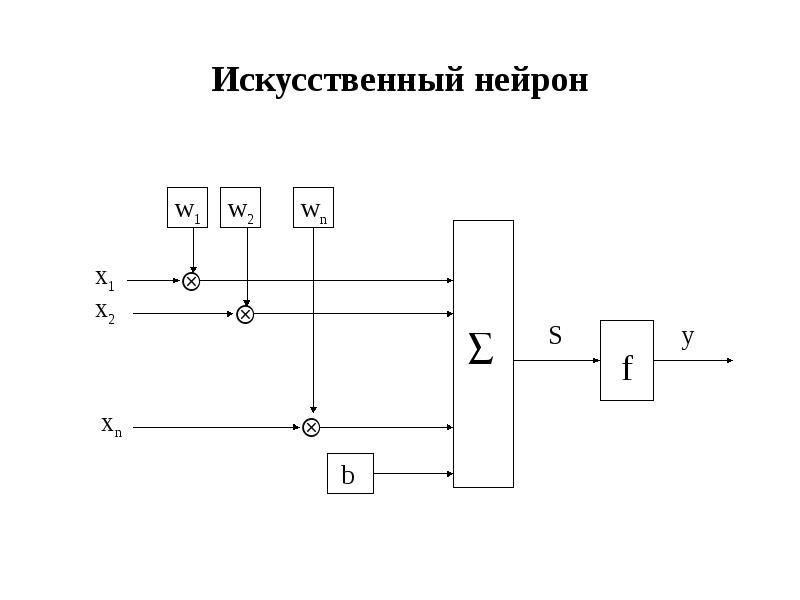

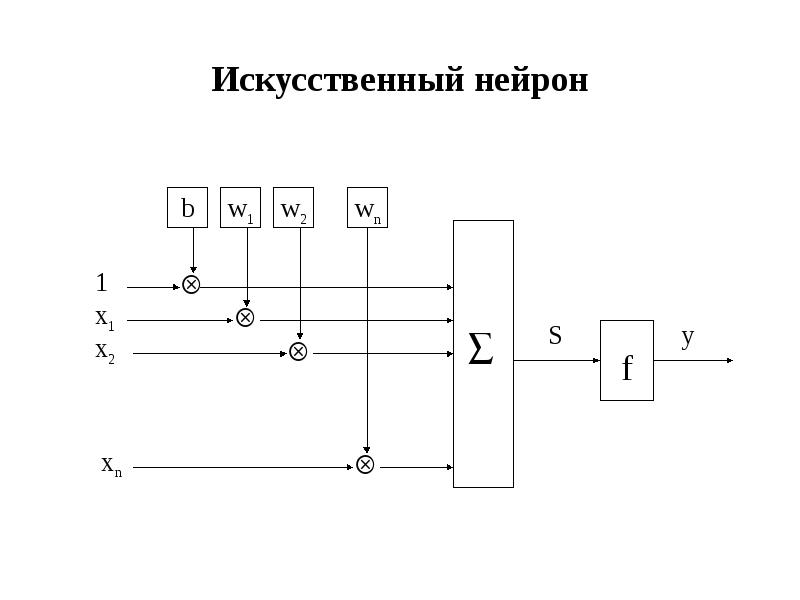

- 10. Искусственный нейрон

- 11. Искусственный нейрон

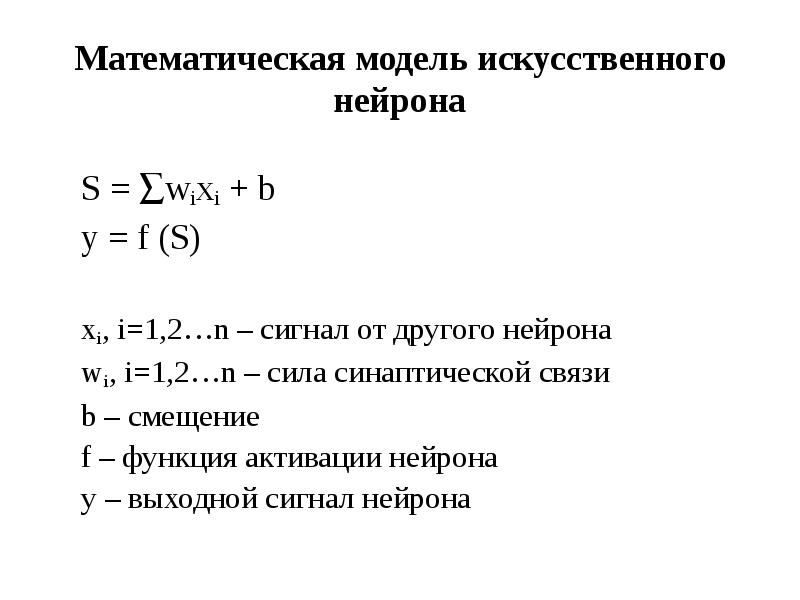

- 12. Математическая модель искусственного нейрона S = wixi + b y =

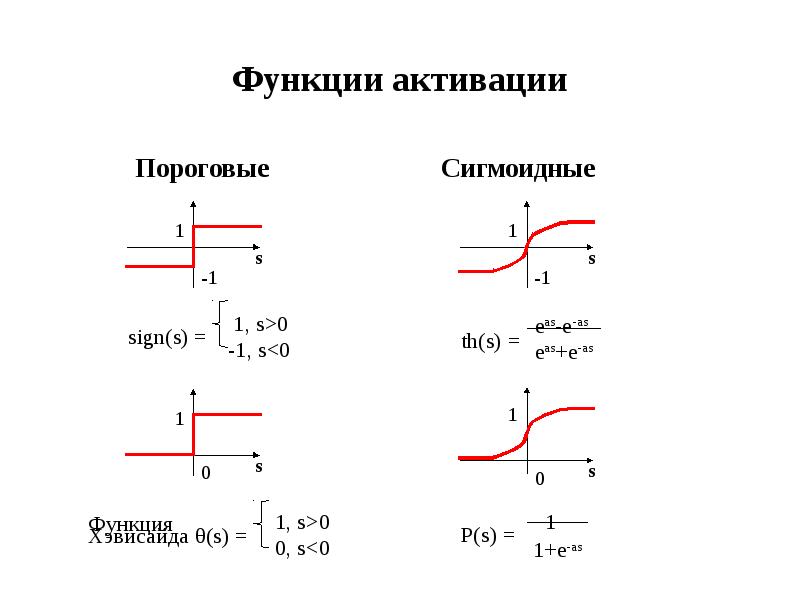

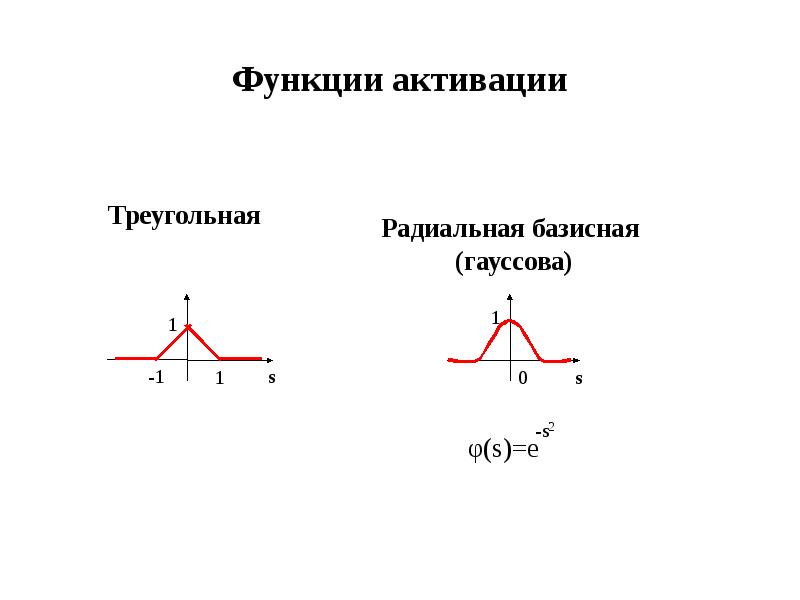

- 13. Функции активации

- 14. Функции активации

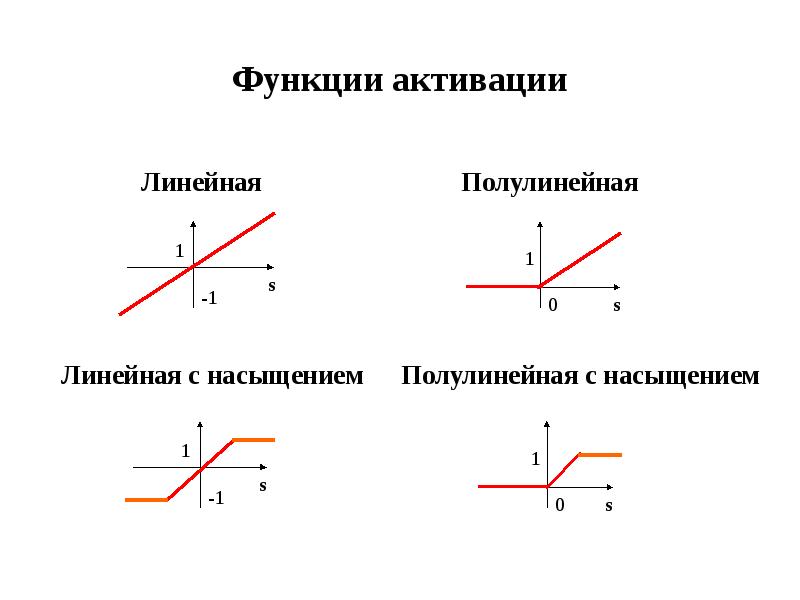

- 15. Функции активации

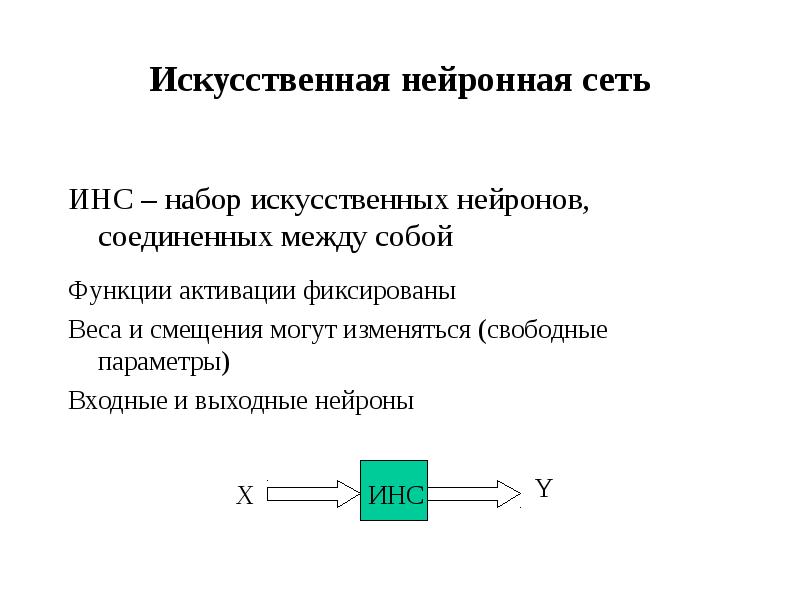

- 16. Искусственная нейронная сеть ИНС – набор искусственных нейронов, соединенных между собой

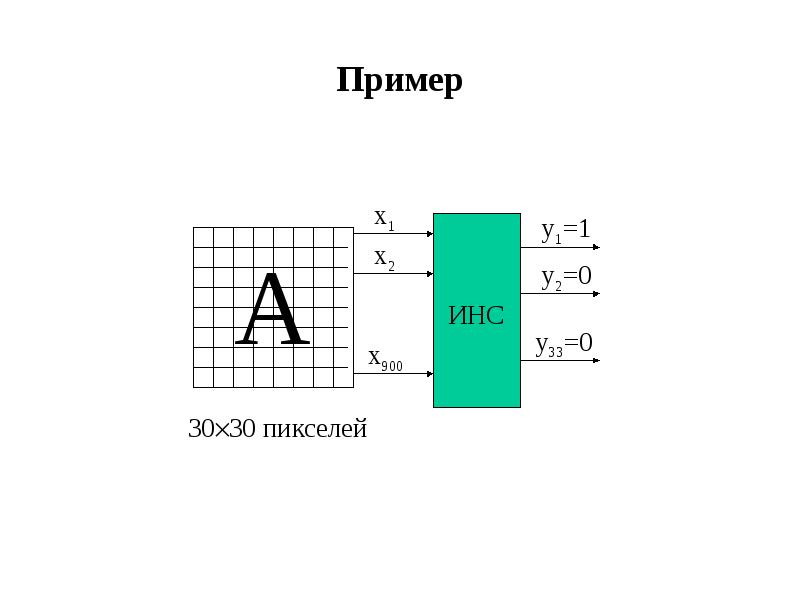

- 17. Пример

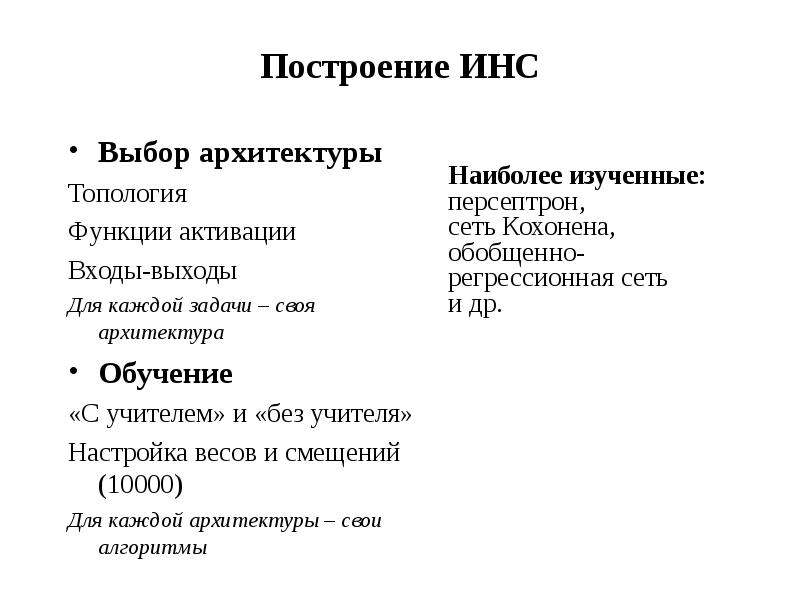

- 18. Построение ИНС Выбор архитектуры Топология Функции активации Входы-выходы Для каждой

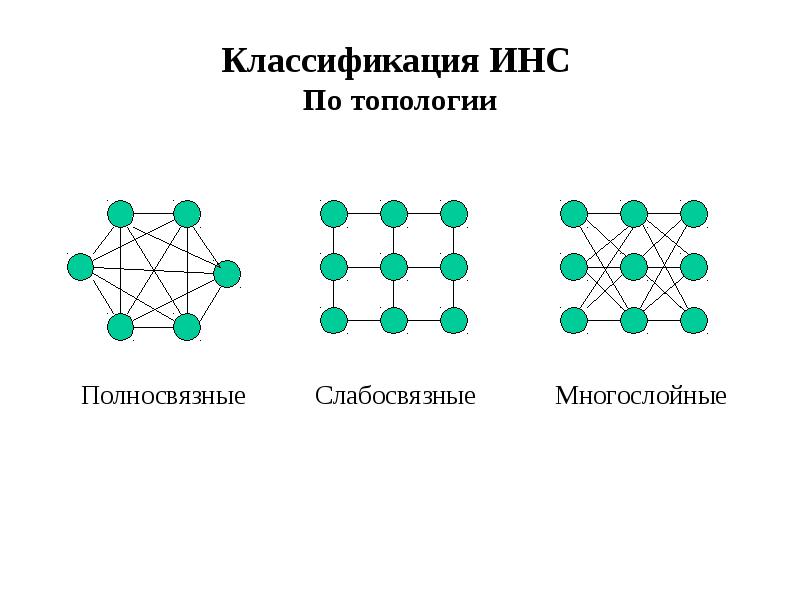

- 19. Классификация ИНС По топологии

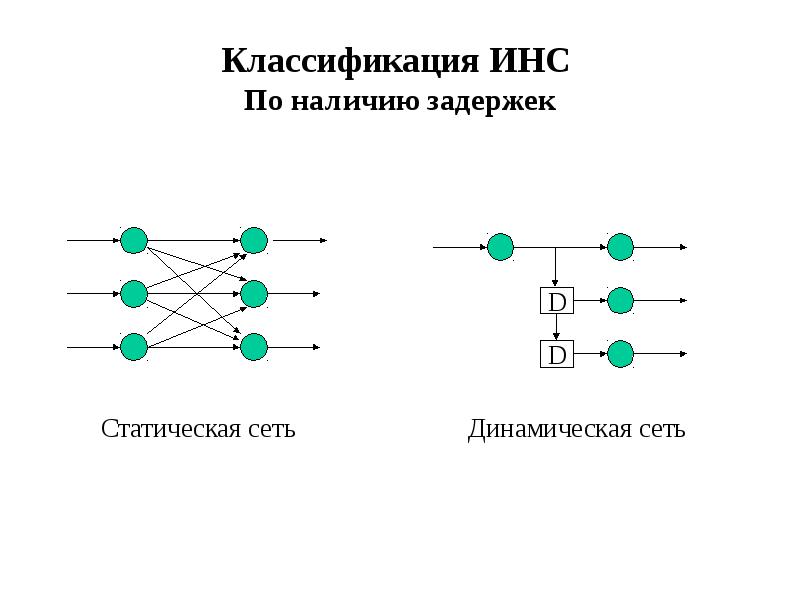

- 20. Классификация ИНС По наличию задержек

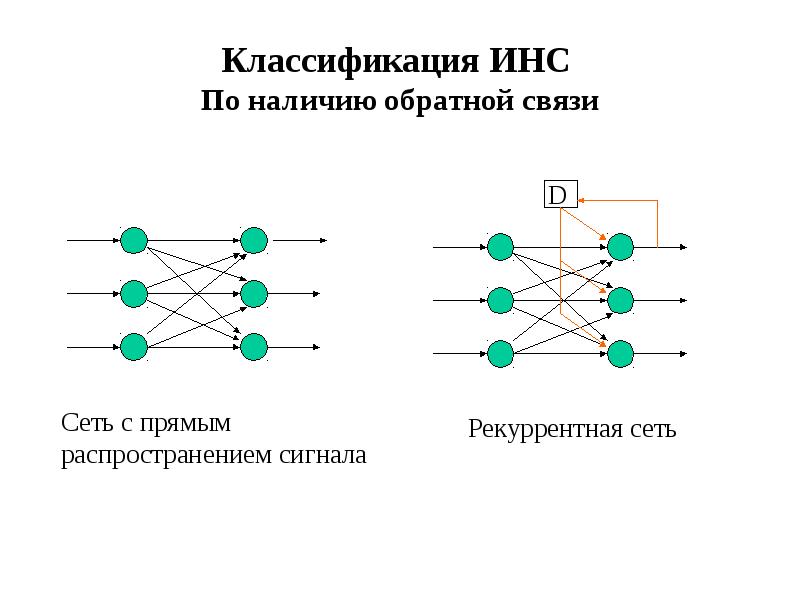

- 21. Классификация ИНС По наличию обратной связи

- 22. По функциям активации По функциям активации Однородные Неоднородные По типу входного

- 23. Увеличение числа слоев и числа нейронов повышает возможности сети, но замедляет

- 24. Обучение ИНС Нейронная сеть – адаптивная система Способность сети обрабатывать информацию

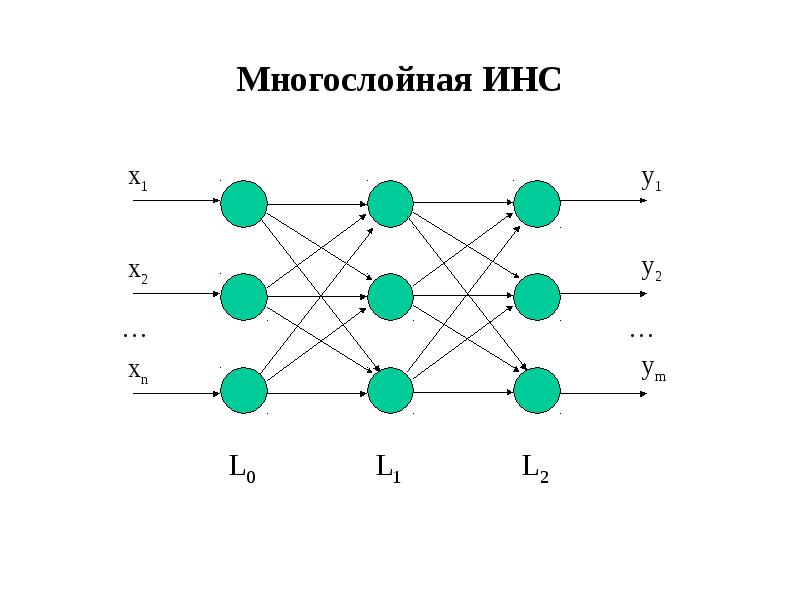

- 25. Многослойная ИНС

- 26. Теоретические результаты Теорема Хехт-Нильсена m-мерная функция от n переменных с заданной

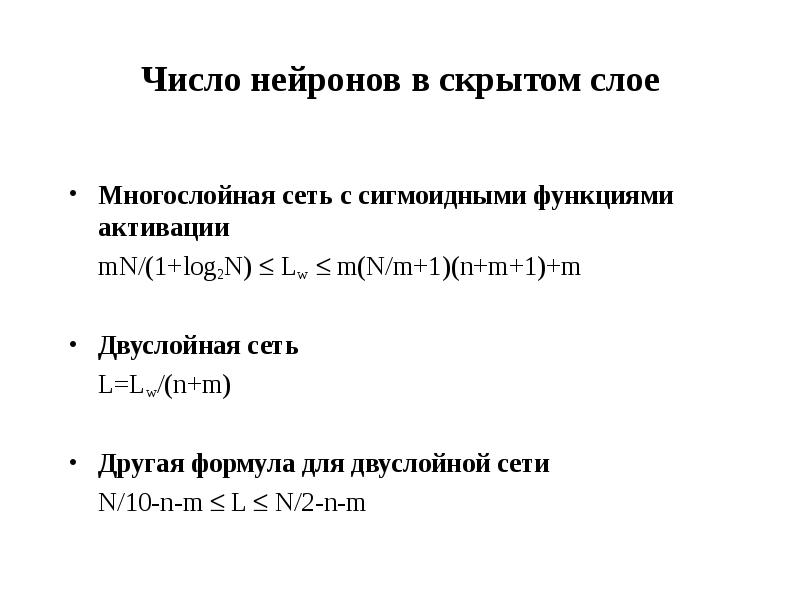

- 27. Число нейронов в скрытом слое Многослойная сеть с сигмоидными функциями активации

- 28. Отсутствует строгая теория, касающаяся Многослойных сетей (число слоев больше 2) Большинства

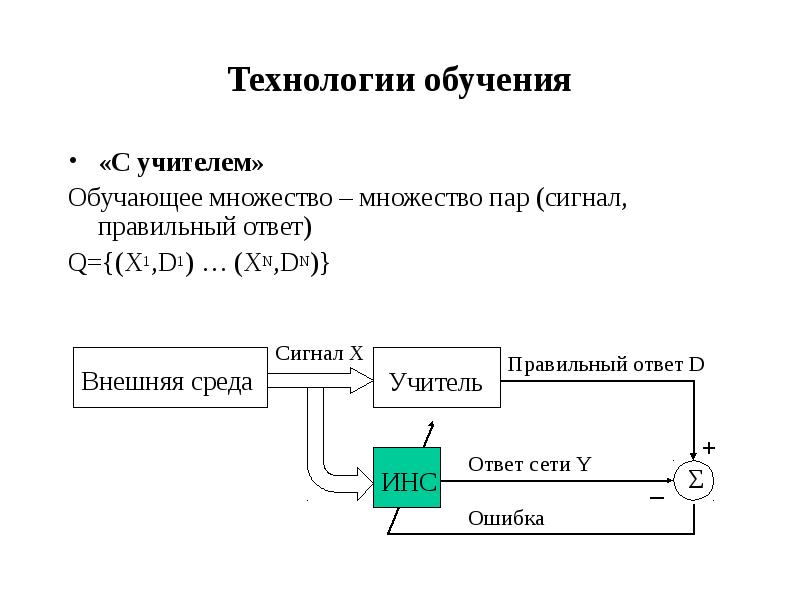

- 29. Технологии обучения «С учителем» Обучающее множество – множество пар (сигнал, правильный

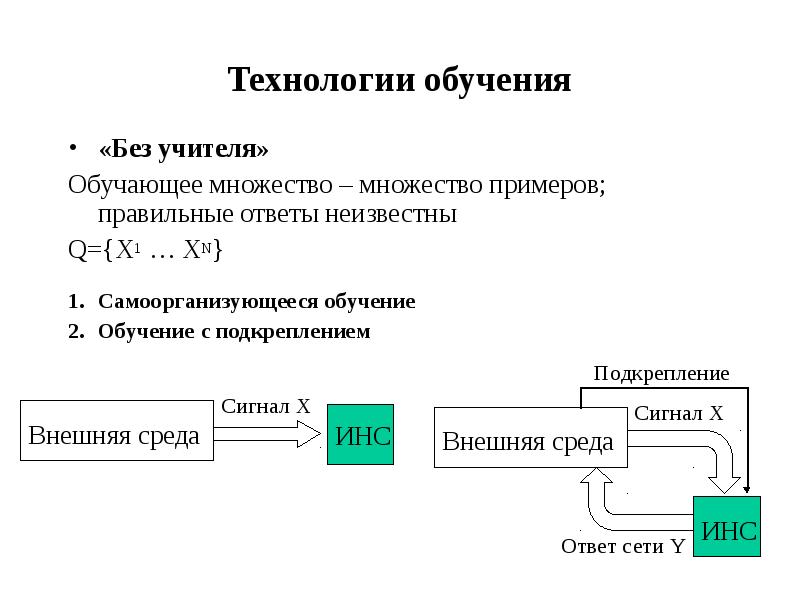

- 30. Технологии обучения «Без учителя» Обучающее множество – множество примеров; правильные ответы

- 31. Обучение «с учителем» Сеть обучена, если она дает правильные ответы на

- 32. Обучение «с учителем» Имеется неизвестная функция Y=F(X), XG Rn, YRm Задано

- 33. Проблемы обучения Недообучение Сеть недостаточно точно аппроксимирует данные обучающего множества (не

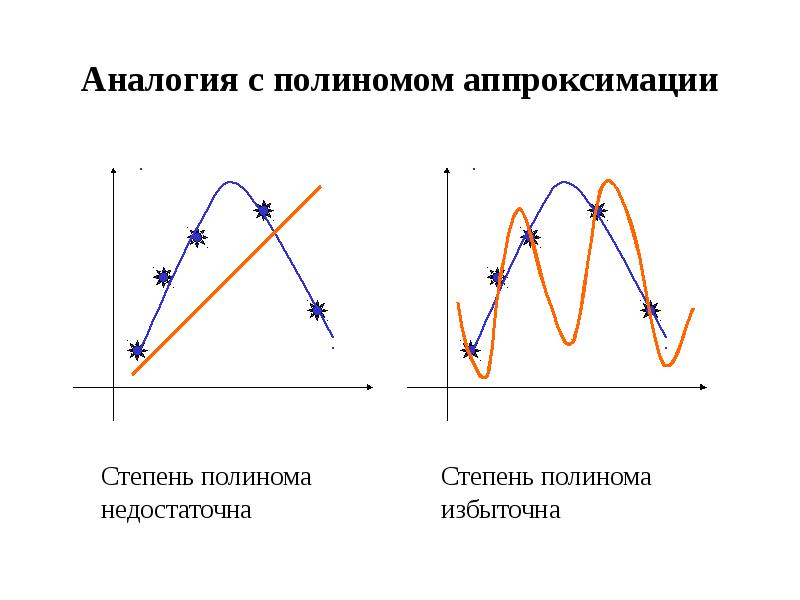

- 34. Аналогия с полиномом аппроксимации

- 35. Контрольное и тестовое множества Как проверить качество обучения? Кросс-проверка Q=Q1Q2 (обучающее+контрольное)

- 36. Обучение ИНС – задача многомерной оптимизации Задача оптимизации: min E(W)

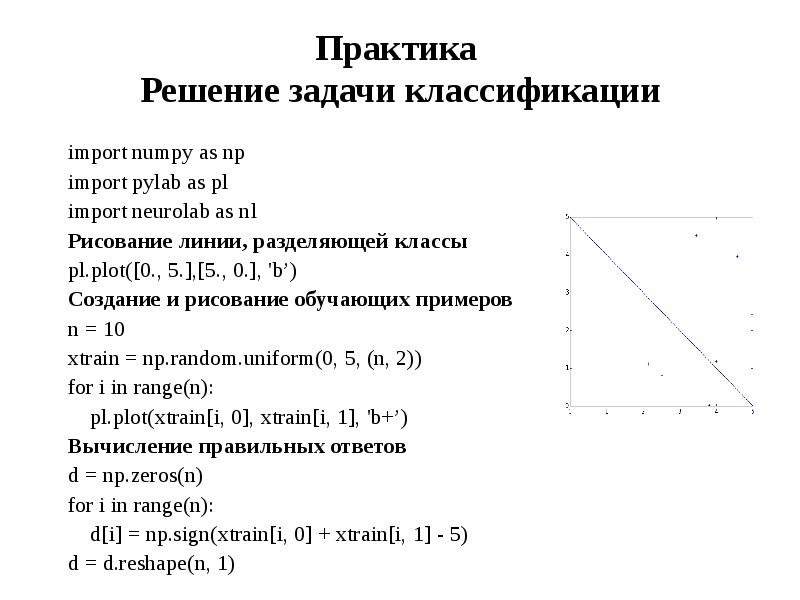

- 37. Практика Решение задачи классификации import numpy as np import pylab as

- 38. Практика Решение задачи классификации Создание сети прямого распространения с сигмоидными функциями

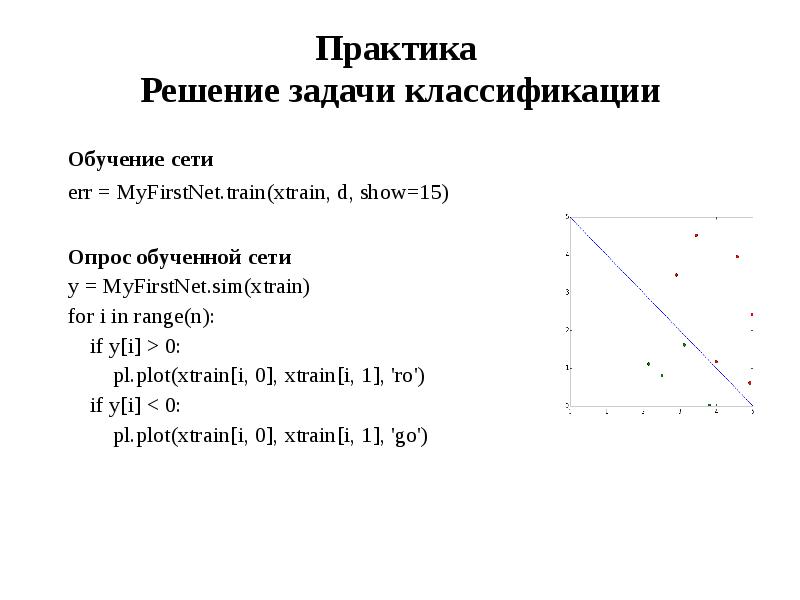

- 39. Практика Решение задачи классификации Обучение сети err = MyFirstNet.train(xtrain, d, show=15)

- 40. Практика Решение задачи классификации Создание тестового множества ntest = 25 *

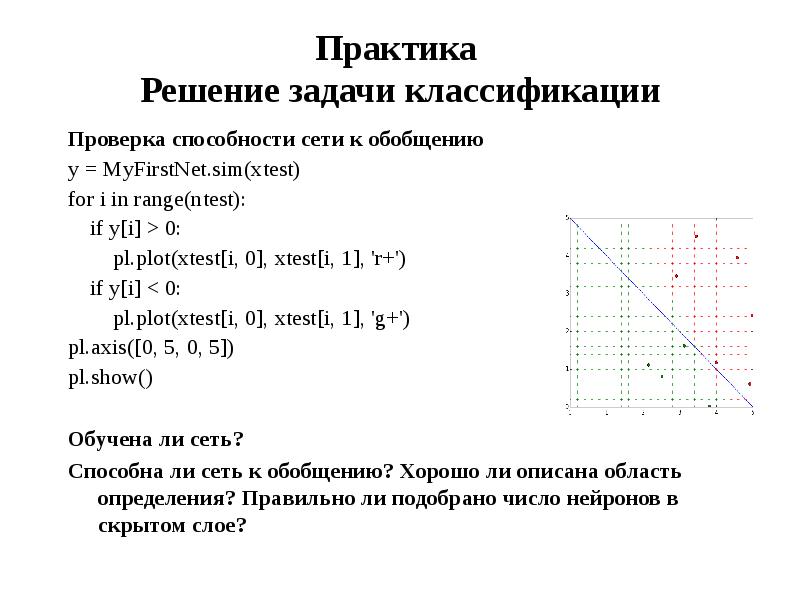

- 41. Практика Решение задачи классификации Проверка способности сети к обобщению y =

- 42. Скачать презентацию

Слайды и текст этой презентации

Похожие презентации