Сокращение размерности пространства признаков при классификации презентация

Содержание

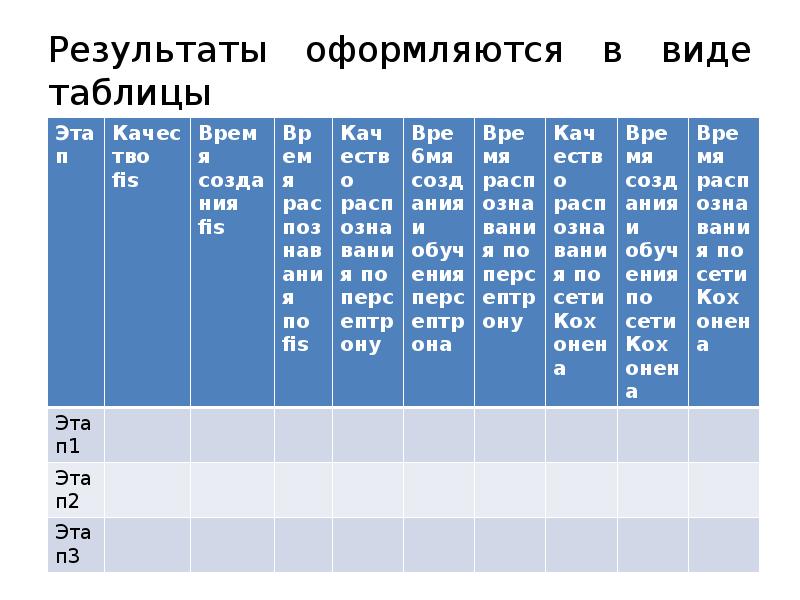

- 2. Результаты оформляются в виде таблицы Результаты оформляются в виде таблицы

- 3. Понижение размерности Это процесс уменьшения анализируемого множества данных до размера,

- 4. Поэтому во втором случае предъявляются очень жесткие требования по отбору данных:

- 5. Подмножество данных, полученное в результате сокращения размерности, должно унаследовать от исходного

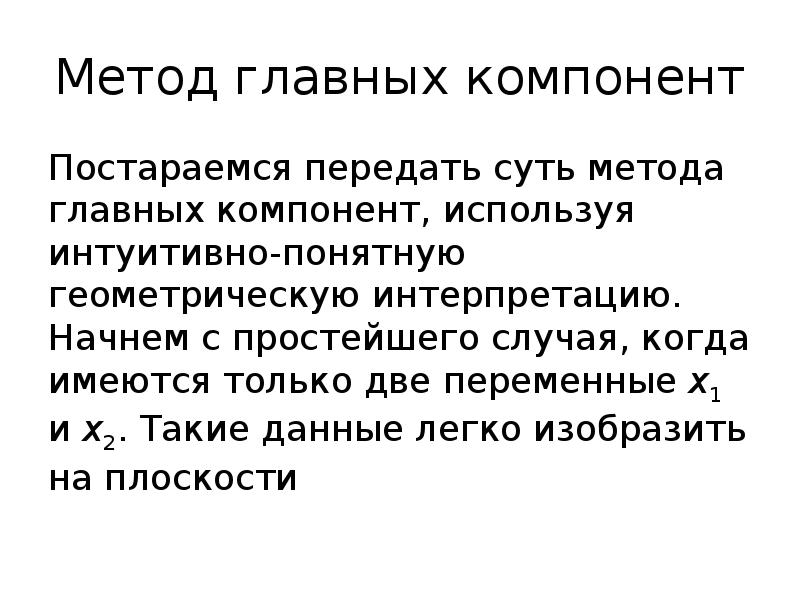

- 6. Метод главных компонент Постараемся передать суть метода главных компонент, используя интуитивно-понятную

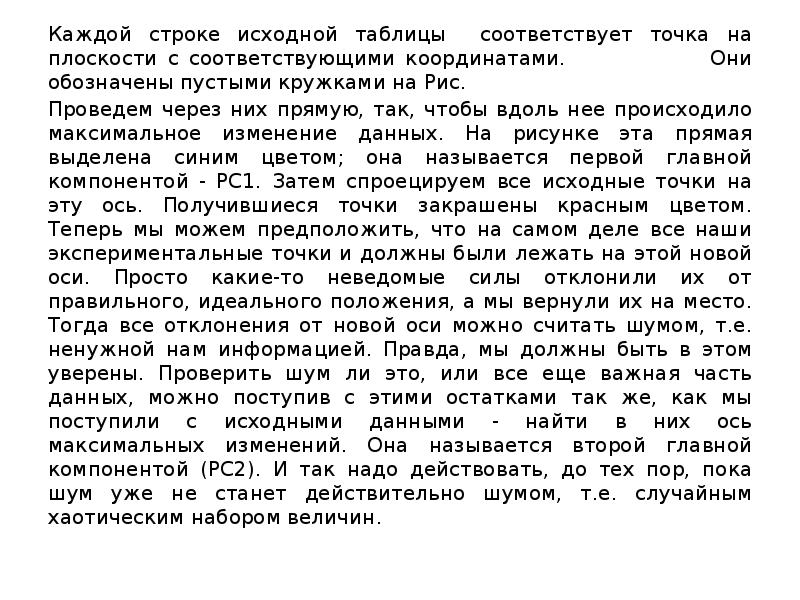

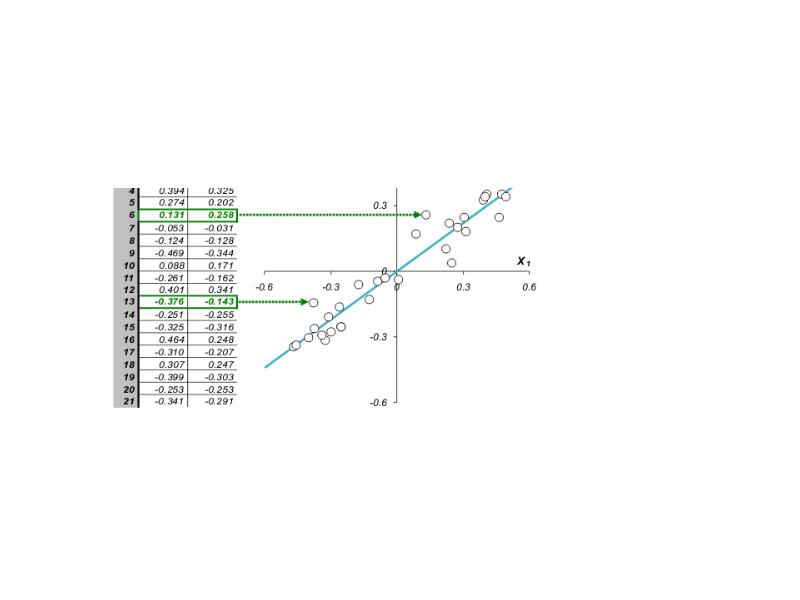

- 7. Графическое представление двумерных данных

- 8. Каждой строке исходной таблицы соответствует точка на плоскости с соответствующими координатами.

- 11. В общем, многомерном случае, процесс выделения главных компонент происходит так:

- 12. В результате, мы переходим от большого количества переменных к новому представлению,

- 13. Суть метода главных компонент - это существенное понижение размерности данных. Исходная

- 14. Формальное описание Пусть имеется матрица переменных X размерностью (I×J), где

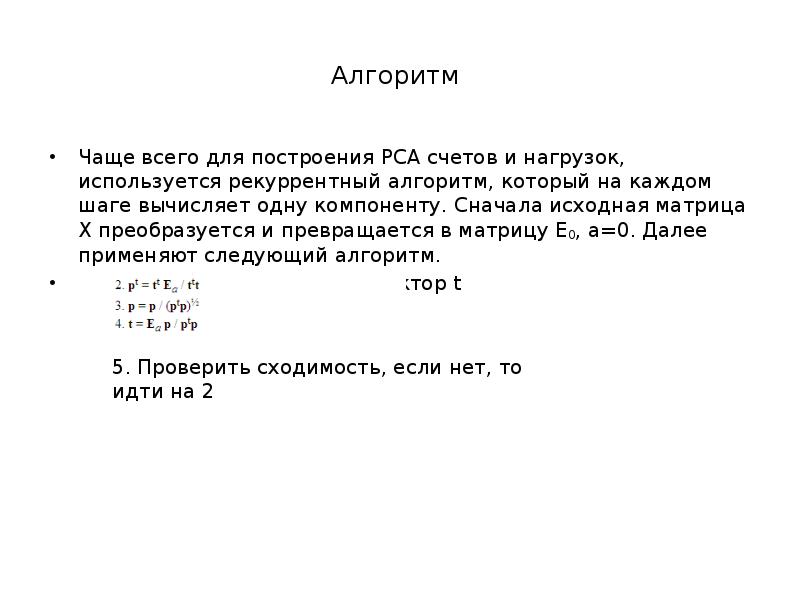

- 16. Алгоритм Чаще всего для построения PCA счетов и нагрузок, используется

- 18. PCA и SVD Метод главных компонент тесно связан с другим

- 19. Собственные векторы и собственные значения Пусть A — это квадратная

- 20. Собственные значения У матрицы A размерности (N×N) не может быть

- 21. Собственные векторы У матрицы A размерности (N×N) не может быть

- 22. Определение главных компонент в Matlab PC = princomp(X) [PC,SCORE,latent,tsquare] = princomp(X)

- 23. [PC,SCORE,latent,tsquare] = princomp(X) функция возвращает матрицу главных компонент PC, матрицу Z-множества

- 24. Пример ирисов Фишера с genfis1 Выполним построение гибридной сети anfis для

- 25. load fisheriris; Xt1=meas(1:25,:); Xt2=meas(51:75,:); Xt3=meas(101:125,:); Xt=[Xt1;Xt2;Xt3]; Yt(1:25)=1; Yt(26:50)=2; Yt(51:75)=3; Xc1=meas(26:50,:); Xc2=meas(76:100,:);

- 26. grid on grid on fis = genfis1(T,[3],char('trimf'),char('constant')) epoch_n = 10; [fis,trn_error]

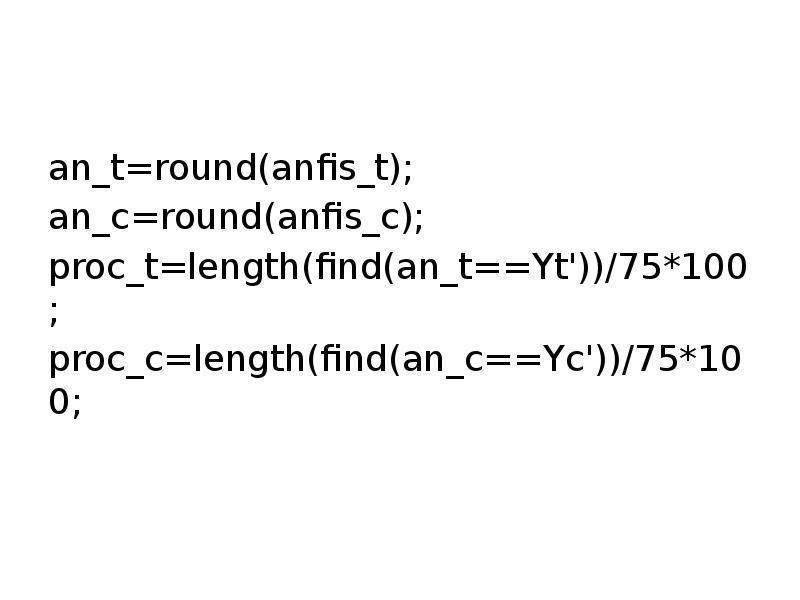

- 27. an_t=round(anfis_t); an_c=round(anfis_c); proc_t=length(find(an_t==Yt'))/75*100; proc_c=length(find(an_c==Yc'))/75*100;

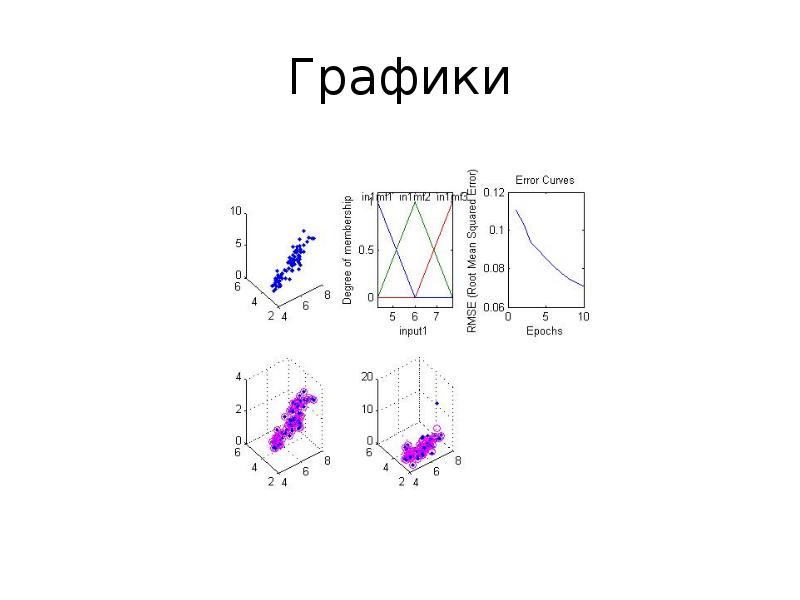

- 28. Графики

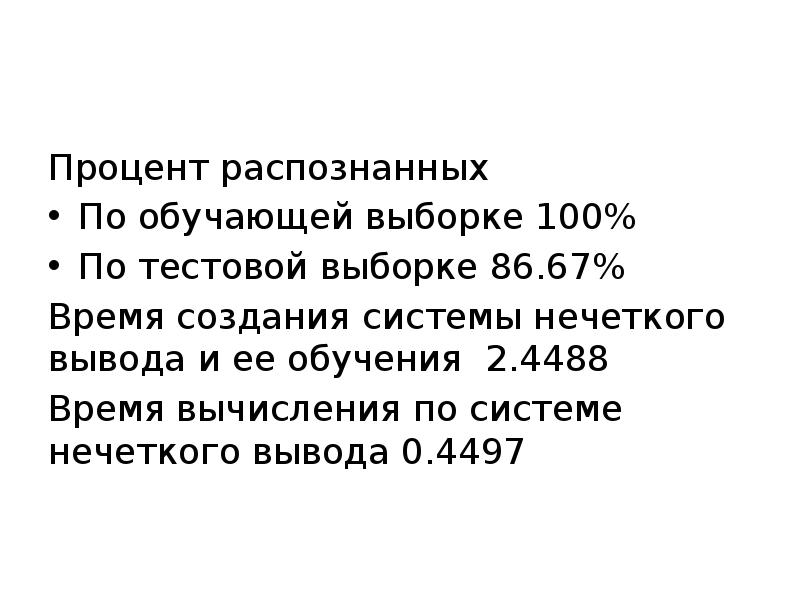

- 29. Процент распознанных По обучающей выборке 100% По тестовой выборке 86.67% Время

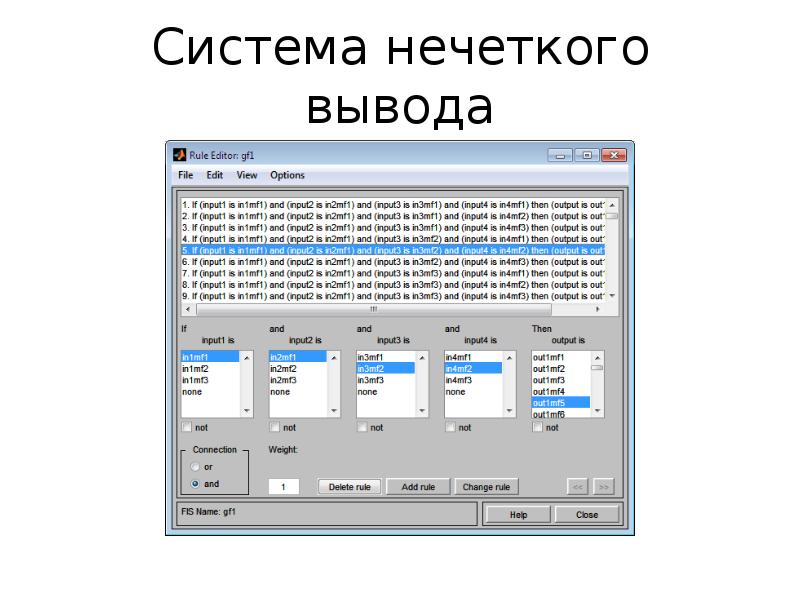

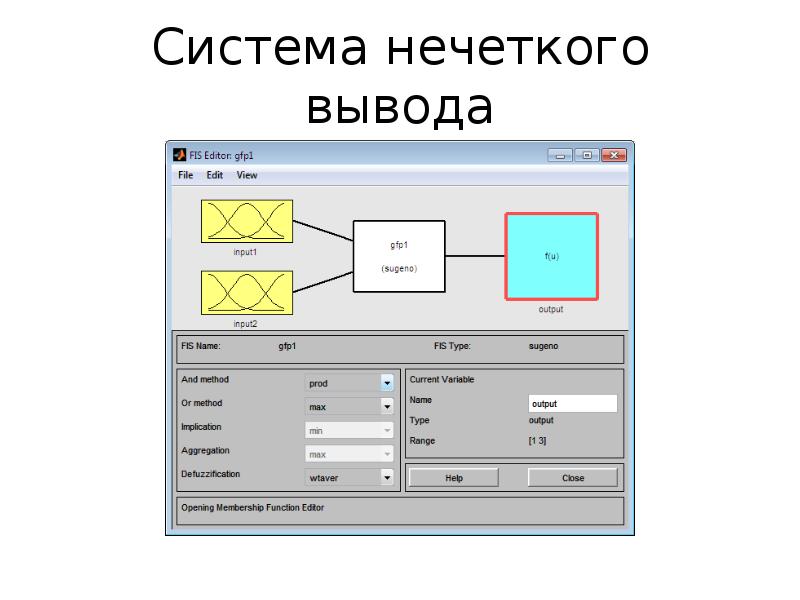

- 30. Система нечеткого вывода

- 31. Метод главных компонент Используем 2 первые главные компоненты Будем стандартизировать

- 32. load fisheriris; stdr = std(meas); meas = meas./repmat(stdr,150,1); [coefs,scores,variances,t2] = princomp(meas);

- 33. Xt=[Xt1;Xt2;Xt3]; T=[Xt Yt']; C=[Xc Yc']; subplot(2,3,1) plot(Xt(:,1),Xt(:,2),' .'); grid on fis

- 34. Xt=[Xt1;Xt2;Xt3]; Xt=[Xt1;Xt2;Xt3]; T=[Xt Yt']; C=[Xc Yc']; subplot(2,3,1) plot(Xt(:,1),Xt(:,2),' .'); grid on

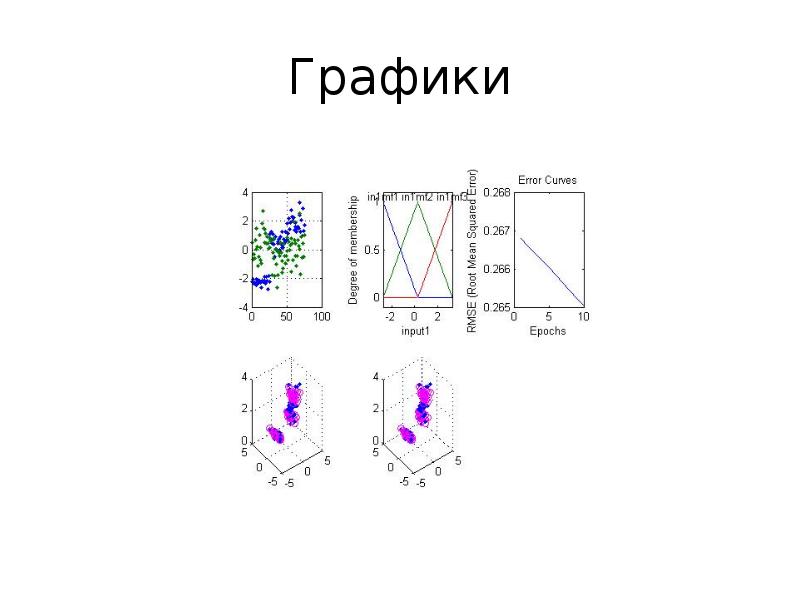

- 35. Графики

- 36. Процент распознанных По обучающей выборке 92% По тестовой выборке 92% Время

- 37. Система нечеткого вывода

- 38. Факторный анализ Многомерные данные часто содержат большое число признаков и часто

- 39. Модель факторного анализа В модели факторного анализа измеренные переменные зависят от

- 40. Модель простого факторного анализа может быть представлена в виде X=μ+λf+e (1)

- 41. Другой формой записи модели простого факторного анализа является выражение Cov(X)=λλT+C (2)

- 42. Функция factoran [lambda,psi] = factoran(X,m) функция возвращает выходной параметр psi

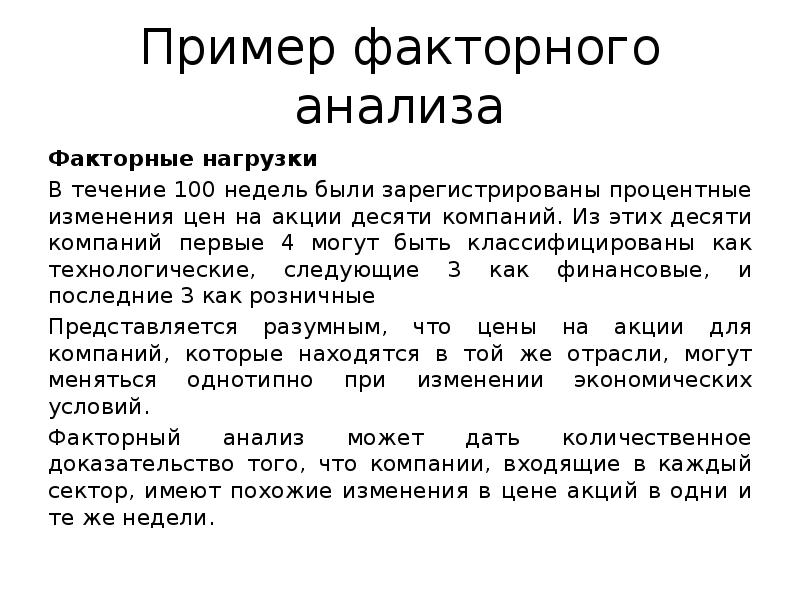

- 43. Пример факторного анализа Факторные нагрузки В течение 100 недель были зарегистрированы

- 44. В этом примере вначале загружаются данные и вызывается функция factoran, определяющая

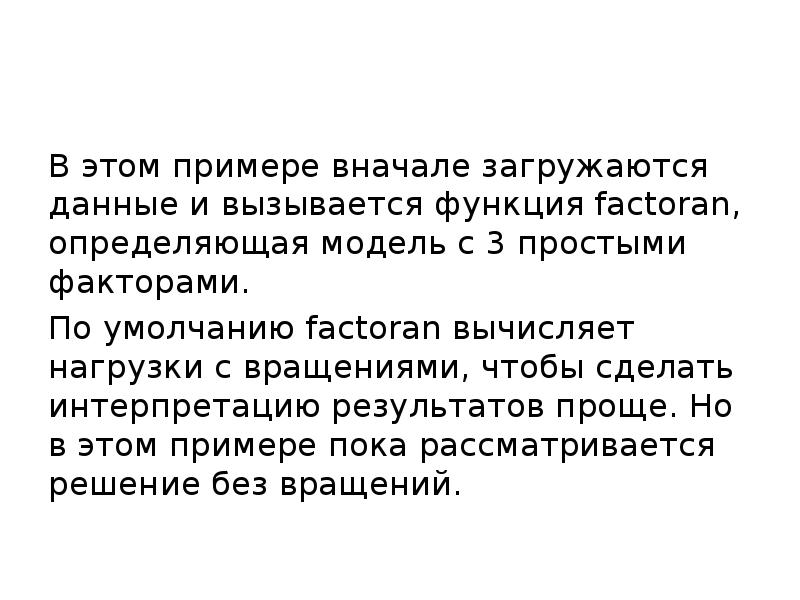

- 45. load stockreturns [Loadings,specificVar,T,stats] = ... factoran(stocks,3,'rotate','none'); Первые два выходных аргумента factoran

- 46. Loadings Loadings = 0.8885 0.2367 -0.2354 0.7126

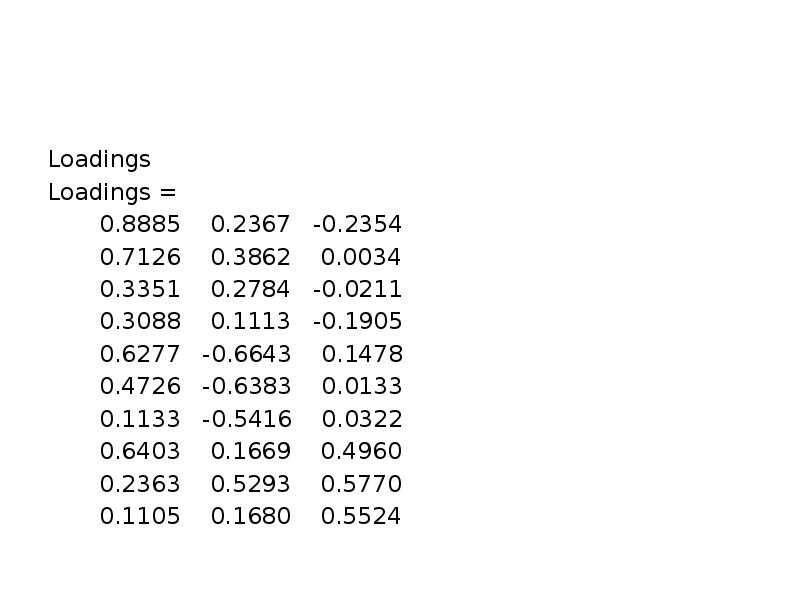

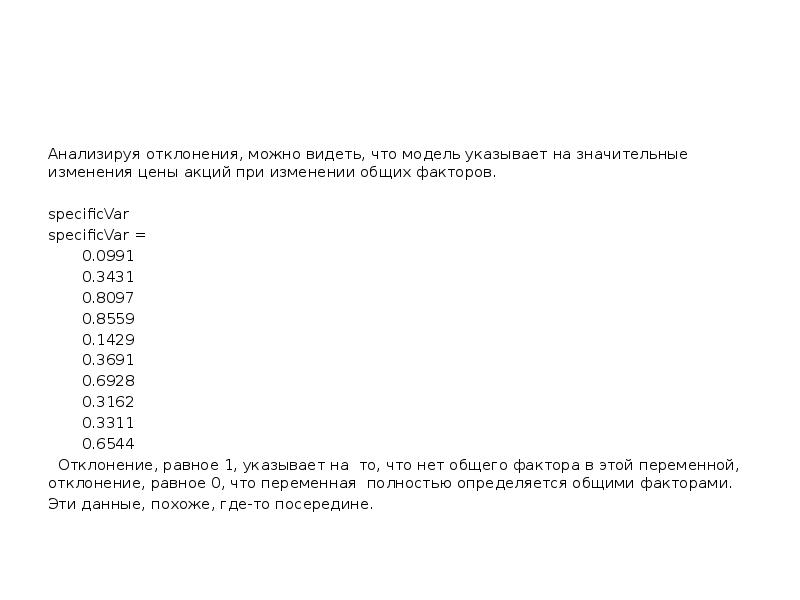

- 47. Анализируя отклонения, можно видеть, что модель указывает на значительные изменения цены

- 48. Структура stats позволяет проверить нулевую гипотезу H0, состоящую в том, что

- 49. Чтобы определить, можно ли выбрать меньшее число факторов, чем 3, построим

- 50. Вращение факторов Как показывают результаты, нагрузки, подсчитанные по факторам, не подвергающимся

- 51. Если рассматривать каждую строку матрицы нагрузок как координаты точки в M-мерном

- 52. [LoadingsPM,specVarPM] = factoran(stocks,3,'rotate','promax'); LoadingsPM LoadingsPM = 0.9452 0.1214 -0.0617

- 53. Вращение promax создает более простую структуру нагрузок, в каждой из которых

- 54. biplot(coefs) создает график коэффициентов матрице coefs. График является двумерным , если

- 55. Наиболее употребимые параметры: Scores Выводит матрицу coefs VarLabels Метки каждого

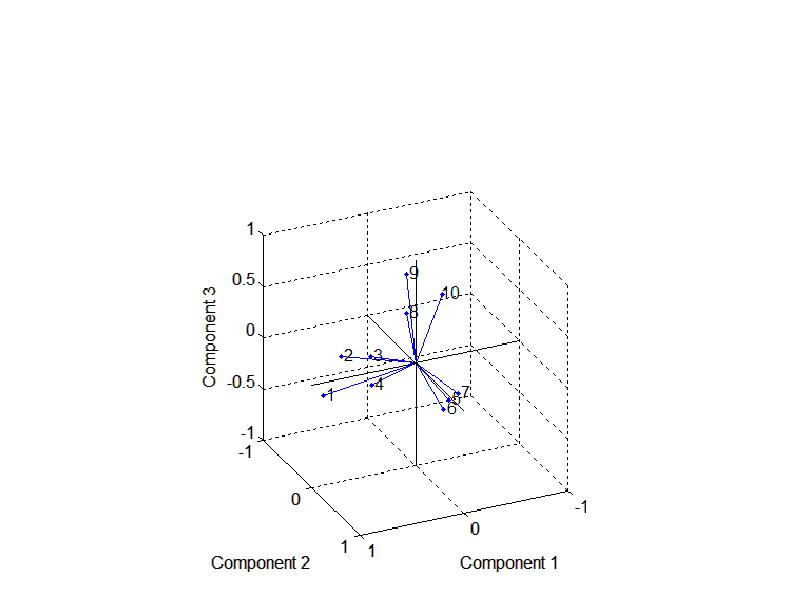

- 56. Для нашего примера biplot(LoadingsPM,'varlabels',num2str((1:10)')); выведет рисунок:

- 58. Этот график показывает, что косоугольное вращение привело нагрузки факторов к простейшей

- 59. Координаты факторов Часто полезно классифицировать наблюдения на основе координат их факторов.

- 60. [LoadingsPM,specVarPM,TPM,stats,F] = ... factoran(stocks, 3,'rotate','promax'); %TPM – матрица вращения %матрица F

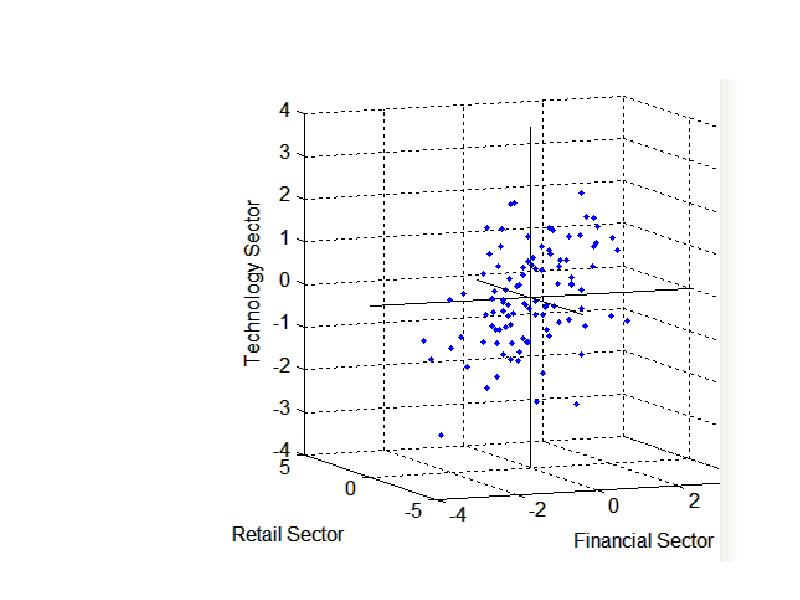

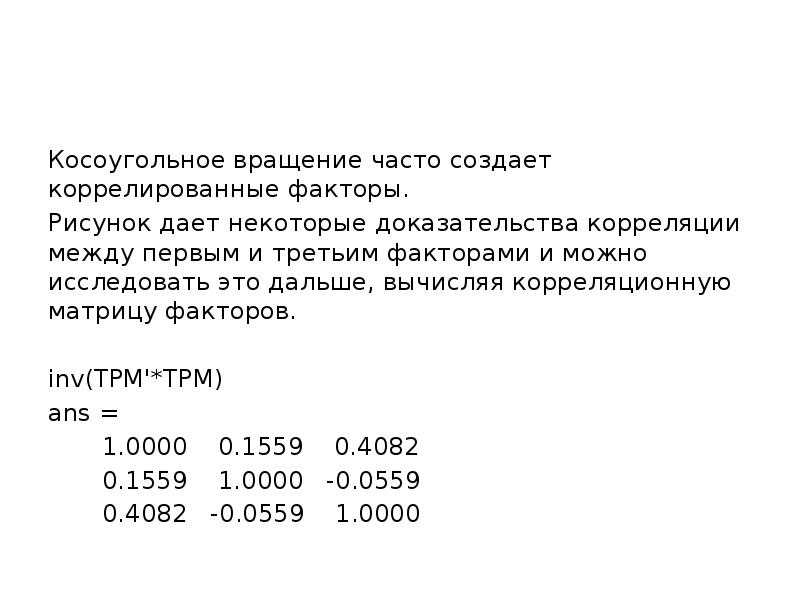

- 62. Косоугольное вращение часто создает коррелированные факторы. Рисунок дает некоторые доказательства

- 63. Визуализация результатов Можно использовать функцию biplot для визуализации факторных нагрузок для

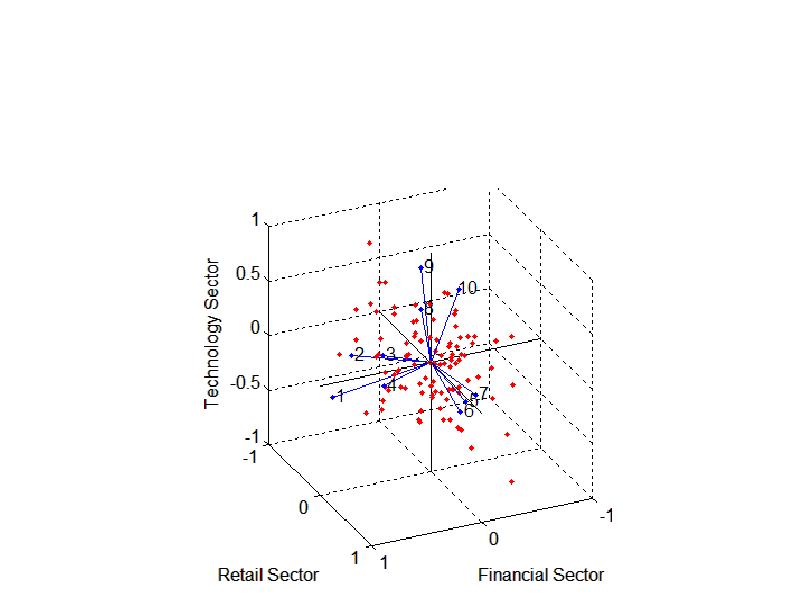

- 65. В этом случае biplot является трехмерным. Каждая из 10 компаний представлена

- 66. Каждое из 100 наблюдений представлено на графике точкой, и их положение

- 67. Пример с ирисами Фишера Так как число признаков d=4,то согласно ограничению

- 68. Создадим модель с косоугольными вращениями и сохраним координаты факторов: [LoadingsPM,specVarPM,TPM,stats,F] =

- 69. load fisheriris [Loadings2,specificVar2,T2,stats2] = ... factoran(meas,1,'rotate','none'); [LoadingsPM,specVarPM,TPM,stats,F] = ... factoran(meas, 1,'rotate','promax');

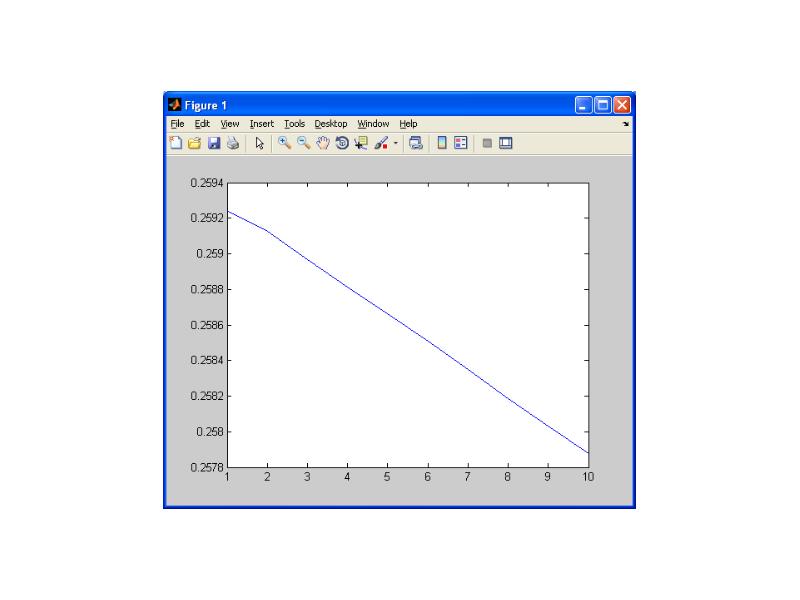

- 70. Построим систему нечеткого вывода с помощью genfis1 и настроим ее с

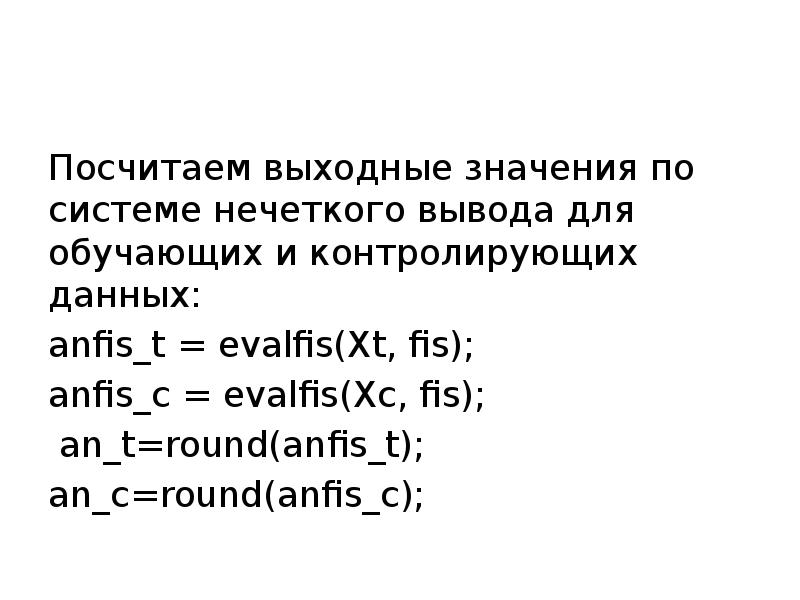

- 72. Посчитаем выходные значения по системе нечеткого вывода для обучающих и контролирующих

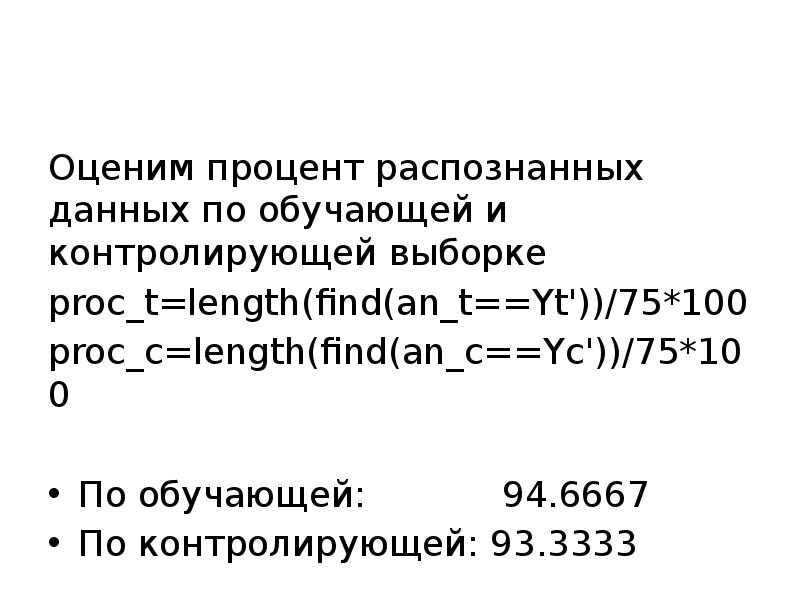

- 73. Оценим процент распознанных данных по обучающей и контролирующей выборке proc_t=length(find(an_t==Yt'))/75*100 proc_c=length(find(an_c==Yc'))/75*100

- 74. Скачать презентацию

![Определение главных компонент в Matlab

PC = princomp(X)

[PC,SCORE,latent,tsquare] = princomp(X)

Определение главных компонент в Matlab

PC = princomp(X)

[PC,SCORE,latent,tsquare] = princomp(X)](/documents_3/5127db3e96683583f465a57b47d90404/img21.jpg)

![[PC,SCORE,latent,tsquare] = princomp(X) функция возвращает матрицу главных компонент PC, матрицу Z-множества [PC,SCORE,latent,tsquare] = princomp(X) функция возвращает матрицу главных компонент PC, матрицу Z-множества](/documents_3/5127db3e96683583f465a57b47d90404/img22.jpg)

![load fisheriris;

Xt1=meas(1:25,:);

Xt2=meas(51:75,:);

Xt3=meas(101:125,:);

Xt=[Xt1;Xt2;Xt3];

Yt(1:25)=1;

Yt(26:50)=2;

Yt(51:75)=3;

Xc1=meas(26:50,:);

Xc2=meas(76:100,:);

load fisheriris;

Xt1=meas(1:25,:);

Xt2=meas(51:75,:);

Xt3=meas(101:125,:);

Xt=[Xt1;Xt2;Xt3];

Yt(1:25)=1;

Yt(26:50)=2;

Yt(51:75)=3;

Xc1=meas(26:50,:);

Xc2=meas(76:100,:);](/documents_3/5127db3e96683583f465a57b47d90404/img24.jpg)

![grid on

grid on

fis = genfis1(T,[3],char('trimf'),char('constant'))

epoch_n = 10; [fis,trn_error] grid on

grid on

fis = genfis1(T,[3],char('trimf'),char('constant'))

epoch_n = 10; [fis,trn_error]](/documents_3/5127db3e96683583f465a57b47d90404/img25.jpg)

![load fisheriris;

stdr = std(meas);

meas = meas./repmat(stdr,150,1);

[coefs,scores,variances,t2] = princomp(meas);

load fisheriris;

stdr = std(meas);

meas = meas./repmat(stdr,150,1);

[coefs,scores,variances,t2] = princomp(meas);](/documents_3/5127db3e96683583f465a57b47d90404/img31.jpg)

![Xt=[Xt1;Xt2;Xt3];

T=[Xt Yt'];

C=[Xc Yc'];

subplot(2,3,1)

plot(Xt(:,1),Xt(:,2),' .');

grid on

fis Xt=[Xt1;Xt2;Xt3];

T=[Xt Yt'];

C=[Xc Yc'];

subplot(2,3,1)

plot(Xt(:,1),Xt(:,2),' .');

grid on

fis](/documents_3/5127db3e96683583f465a57b47d90404/img32.jpg)

![Xt=[Xt1;Xt2;Xt3];

Xt=[Xt1;Xt2;Xt3];

T=[Xt Yt'];

C=[Xc Yc'];

subplot(2,3,1)

plot(Xt(:,1),Xt(:,2),' .');

grid on

Xt=[Xt1;Xt2;Xt3];

Xt=[Xt1;Xt2;Xt3];

T=[Xt Yt'];

C=[Xc Yc'];

subplot(2,3,1)

plot(Xt(:,1),Xt(:,2),' .');

grid on](/documents_3/5127db3e96683583f465a57b47d90404/img33.jpg)

![Функция factoran

[lambda,psi] = factoran(X,m)

функция возвращает выходной параметр psi Функция factoran

[lambda,psi] = factoran(X,m)

функция возвращает выходной параметр psi](/documents_3/5127db3e96683583f465a57b47d90404/img41.jpg)

![load stockreturns

[Loadings,specificVar,T,stats] = ...

factoran(stocks,3,'rotate','none');

Первые два выходных аргумента load stockreturns

[Loadings,specificVar,T,stats] = ...

factoran(stocks,3,'rotate','none');

Первые два выходных аргумента](/documents_3/5127db3e96683583f465a57b47d90404/img44.jpg)

![[LoadingsPM,specVarPM] = factoran(stocks,3,'rotate','promax');

LoadingsPM

LoadingsPM =

0.9452 [LoadingsPM,specVarPM] = factoran(stocks,3,'rotate','promax');

LoadingsPM

LoadingsPM =

0.9452](/documents_3/5127db3e96683583f465a57b47d90404/img51.jpg)

![[LoadingsPM,specVarPM,TPM,stats,F] = ...

factoran(stocks, 3,'rotate','promax');

%TPM – матрица вращения

%матрица [LoadingsPM,specVarPM,TPM,stats,F] = ...

factoran(stocks, 3,'rotate','promax');

%TPM – матрица вращения

%матрица](/documents_3/5127db3e96683583f465a57b47d90404/img59.jpg)

![Создадим модель с косоугольными вращениями и сохраним координаты факторов:

[LoadingsPM,specVarPM,TPM,stats,F] = Создадим модель с косоугольными вращениями и сохраним координаты факторов:

[LoadingsPM,specVarPM,TPM,stats,F] =](/documents_3/5127db3e96683583f465a57b47d90404/img67.jpg)

![load fisheriris

[Loadings2,specificVar2,T2,stats2] = ...

factoran(meas,1,'rotate','none');

[LoadingsPM,specVarPM,TPM,stats,F] = ...

load fisheriris

[Loadings2,specificVar2,T2,stats2] = ...

factoran(meas,1,'rotate','none');

[LoadingsPM,specVarPM,TPM,stats,F] = ...](/documents_3/5127db3e96683583f465a57b47d90404/img68.jpg)

Слайды и текст этой презентации

Скачать презентацию на тему Сокращение размерности пространства признаков при классификации можно ниже:

Похожие презентации